Un trabajo internacional en el que participa la Universidad Autónoma de Madrid (UAM) ha comparado distintos métodos de aprendizaje automático basados en la técnica Gradient Boosting

Un trabajo en el que participa la Universidad Autónoma de Madrid (UAM), publicado recientemente en Artificial Intelligence Review, ha analizado una familia de algoritmos de aprendizaje automático conocida como Gradient Boosting y su ampliación con técnicas avanzadas como XGBoost, LightGBM y CatBoost.

Los posibles campos de aplicación de estos modelos, tanto en ciencia como en desarrollos empresariales, son numerosísimos y van desde la medicina hasta la astronomía, detección de moléculas o predicción de producción energética.

Además del interés intrínseco en el campo de la inteligencia artificial, el trabajo constituye una vía de acceso para investigadores y profesionales de cualquier área que quieran aplicar estas técnicas novedosas en su trabajo diario de forma eficiente.

Las propuestas se centran tanto en mejorar la velocidad de creación de los modelos como en mejorar su capacidad de generalización. “XGBoost es una técnica escalable que ha demostrado ser capaz de resolver no pocos desafíos de aprendizaje automático de forma eficiente. LightGBM es un modelo preciso centrado en proporcionar un rendimiento computacional en el proceso de entrenamiento del modelo extremadamente rápido utilizando un muestreo selectivo de instancias. Y CatBoost modifica el cálculo de gradientes para reducir el sesgo en el proceso de entrenamiento y así mejorar la precisión del modelo”, describen los autores.

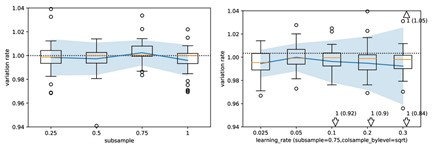

Análisis de la hiperparametrización de XGBoost donde se muestra la variación en el desempeño sobre los conjuntos de datos analizados / UAM

Comparativa de modelos

Como parte del trabajo los investigadores realizaron un análisis práctico de cómo funcionan estas nuevas variantes de algoritmos de aprendizaje automático basadas en Gradient Boosting. “En concreto —explican—, se ha hecho una comparativa en términos de velocidad de entrenamiento de los modelos, de capacidad de generalización y de facilidad de configuración de sus hiperparámetros”.

“Además —agregan—, se ha realizado una comparación ampliada entre XGBoost, LightGBM y CatBoost con respecto a Random Forest y el algoritmo Gradient Boosting original. Todos los modelos fueron cuidadosamente ajustados, y se analizaron sus configuraciones predeterminadas”.

Los resultados de esta comparación indican que CatBoost obtiene los mejores resultados en precisión de generalización en los conjuntos de datos estudiados, aunque las diferencias son pequeñas. LightGBM es el más rápido de todos los métodos, pero no el más preciso. Finalmente, XGBoost ocupa el segundo lugar tanto en precisión como en velocidad de entrenamiento.

Además, los investigadores llevaron a cabo un análisis exhaustivo del efecto del ajuste de hiperparámetros en XGBoost, LightGBM y CatBoost. Para ello, propusieron dos metodologías novedosas para analizar el ajuste de hiperparámetros.

“En la primera propuesta estudiamos cómo varía la precisión de los modelos cuando se cambia el valor de cada uno de los hiperparámetros del modelo a cualquier otro valor. La segunda propuesta para el análisis del ajuste de los hiperparámetros de los modelos es una herramienta visual que analiza cómo varía el rendimiento de un método para un conjunto de problemas de aprendizaje automático cuando un hiperparámetro se fija a un valor dado, es decir, cuando el hiperparámetro no es optimizado”, detallan los investigadores.

En suma, estas herramientas permitirán analizar cuáles son los hiperparámetros de los modelos más importantes de optimizar y permitirán ahorrar mucho tiempo de computación en la creación de los modelos óptimos.

El trabajo es resultado de una colaboración entre los investigadores Candice Bentèjac, de la Universidad de Burdeos; Anne Csörgő, de la Universidad Católica Pázmány Péter de Budapest, y Gonzalo Martínez Muñoz, de la UAM.

Referencia bibliográfica:

Bentéjac, C., Csörgő, A., Martínez-Muñoz, G. 2020. A comparative analysis of gradient boosting algorithms. Artificial Intelligence Review. https://doi.org/10.1007/s10462-020-09896-5