Los resultados, publicados en la revista Neurocomputing, podrían asistir la toma de decisiones en situaciones delicadas, como las asociadas al contexto médico o a la conducción autónoma

Los investigadores Simón Rodríguez Santana, del Instituto de Ciencias Matemáticas (ICMAT), y Daniel Hernández Lobato, de la Universidad Autónoma de Madrid (UAM), han presentado un nuevo método que extiende y mejora la formulación existente dentro del aprendizaje automático probabilístico.

Este método, denominado ‘minimización adversaria de alfa-divergencias’ (AADM, por sus siglas en inglés), supone un importante avance en la expresividad y la flexibilidad de los métodos de aprendizaje automático probabilístico.

De acuerdo con el trabajo, publicado en Neurocomputing, el empleo de AADM permitirá una mayor adaptación de las técnicas de aprendizaje automático en situaciones complejas, es decir, en aquellas donde resulta necesaria una comprensión detallada de la situación y de las probabilidades de los resultados predichos.

Estos resultados pueden ser especialmente relevantes en procesos de toma de decisiones en situaciones delicadas, como las que se pueden dar en el contexto médico o en la conducción autónoma, donde el aprendizaje automático probabilístico es empleado por las ventajas asociadas a esa información extra, ya que distintas decisiones pueden implicar consecuencias radicalmente diferentes.

Aprendizaje automático probabilístico

La perspectiva del aprendizaje automático probabilístico extiende las técnicas del casi ubicuo aprendizaje automático “usual” para obtener no solo predicciones, sino también las probabilidades asociadas a las mismas. Pero, ¿por qué es esto importante si las predicciones pueden ser buenas de por sí?

El motivo principal es que permite obtener más información, reflejando la incertidumbre de los algoritmos cuando se encuentran, por ejemplo, con situaciones complejas o incluso nunca antes vistas.

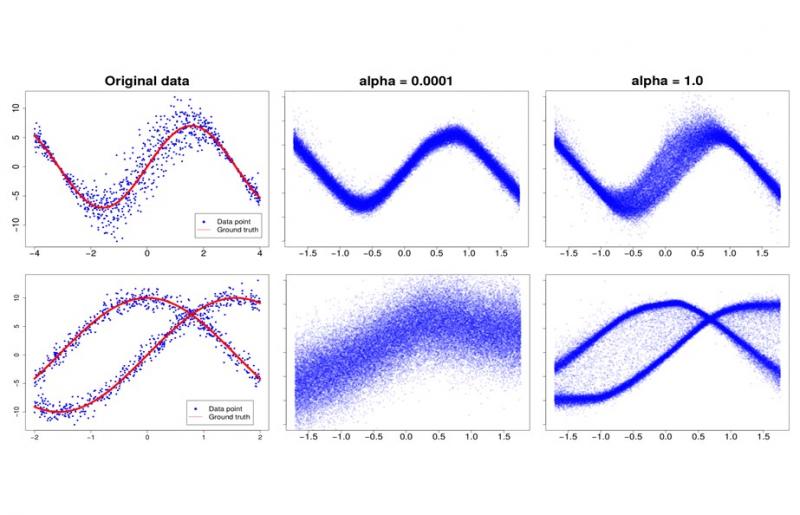

Resultados de los problemas de juguete. Los puntos azules de la izquierda representan los datos originales y el comportamiento subyacente (líneas rojas). En el medio, las predicciones generadas con α ≈ 0 (es decir, AVB regular), y en el lado derecho están las predicciones con α = 1.0.

“Desde el punto de vista Bayesiano, esto implica obtener distribuciones predictivas que informen sobre las distintas probabilidades para los resultados predichos. Sin embargo, esta no es una tarea sencilla y en muchas ocasiones se recurre a un compromiso, empleando simplificaciones que puedan facilitar el tratamiento pero que, en última instancia, pueden llegar a afectar negativamente a la calidad de las predicciones en sí”, señalan los autores.

Minimización adversaria de alfa-divergencias

El método AADM se basa en el uso dos sistemas que compiten entre sí para la optimización de un objetivo más general de lo usual en técnicas similares. Esto es posible mediante el uso de alfa-divergencias, una clase de medidas que permiten cuantificar las diferencias entre dos distribuciones de probabilidad.

“En concreto, las alfa-divergencias permiten controlar la expresividad de la distribución predictiva en función de la tarea y de los datos presentes. Permiten representar una generalización respecto a otras medidas de divergencia empleadas usualmente, las cuales pueden ser recuperadas simplemente fijando alfa a valores concretos”, detallan los autores.

Para ser capaces de explotar estas propiedades, los autores enfrentan dos sistemas entre sí, lo cual permite estimar de manera suficientemente precisa el objetivo final para entrenar AADM.

AADM es capaz de proporcionar distribuciones más expresivas y representativas de lo que se era capaz hasta el momento con técnicas similares, captando detalles importantes incluso en situaciones con datos complejos, y todo por el mismo coste computacional.

“Esto permite que las predicciones sean más fieles y representativas de los datos originales, evitando padecer los problemas que conllevan algunas de las sobresimplificaciones presentes en otros métodos”, apuntan los autores.

“Además —agregan—, la flexibilidad asociada a las predicciones de AADM puede ser controlada seleccionando diferentes valores para alfa. En el trabajo demostramos mediante diversos experimentos que valores intermedios para este parámetro producen mejores resultados que los métodos previos”.

Referencia bibliográfica:

Rodríguez-Santana, S., Hernández-Lobato, D. 2022. Adversarial α-divergence minimization for Bayesian approximate inference. Neurocomputing, 471: 260-274. doi: 10.1016/j.neucom.2020.09.076.